Loading the Elevenlabs Text to Speech AudioNative Player…

Ten artykuł jest częścią serii “Tłumaczymy! Naukowe świeżynki”, do której zapraszamy ekspertów, by dla nas objaśniali aktualne publikacje naukowe z dziedziny sztucznej inteligencji.

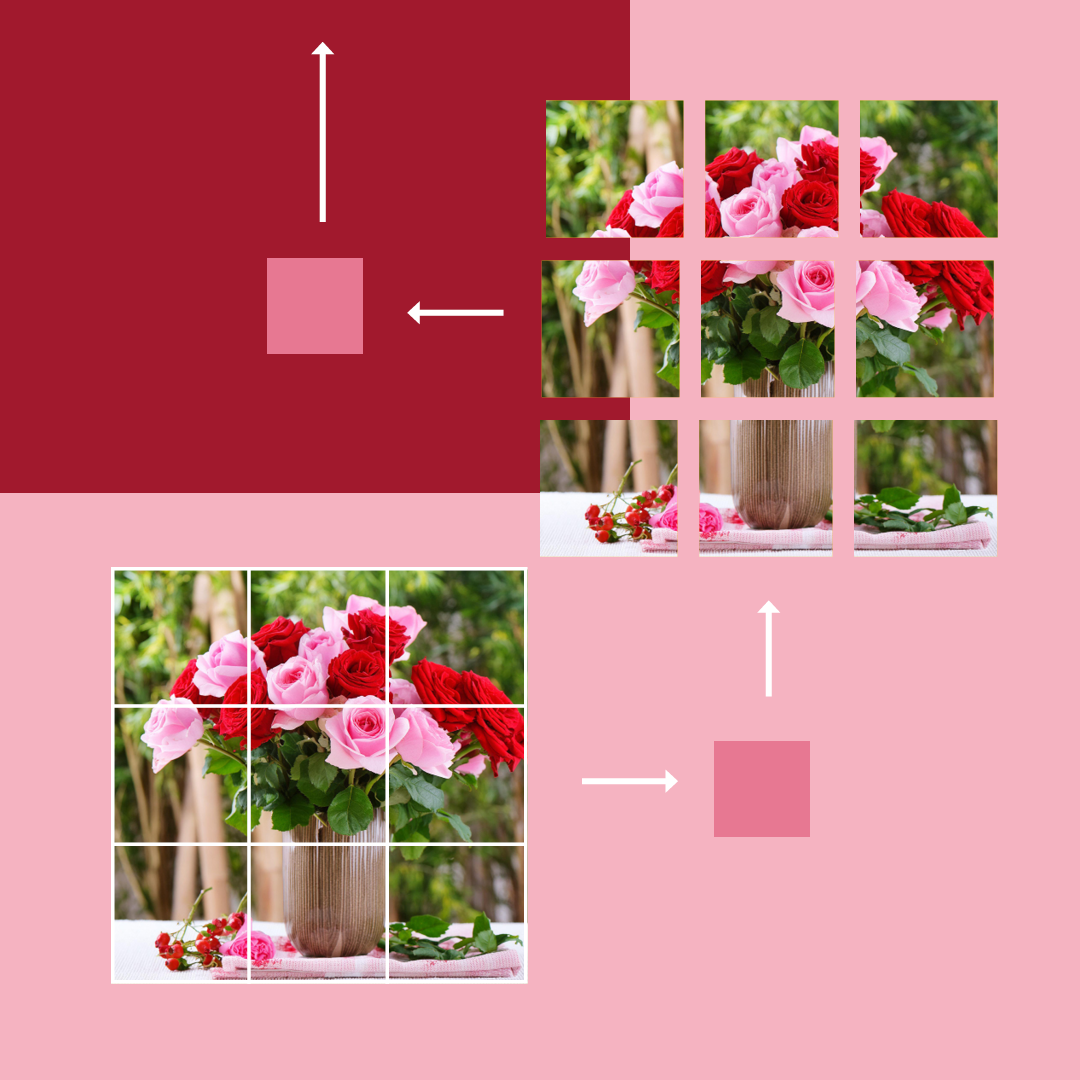

W ramach swojej pracy “MM1: Methods, Analysis & Insights from Multimodal LLM Pre-training“ naukowcy z Apple’a postanowili przygotować „przepis na sukces”, czyli opracować wskazówki, jak wytrenować modele, aby odpowiednio analizowały wielomodalne wejścia i prawidłowo wykonywały instrukcje. Skupili się przy tym na dwóch aspektach: na architekturze modeli oraz danych treningowych. Przyjrzyjmy się bliżej temu, co opisali i co z tego wynika.